Presentation

La présentation du projet et les travaux faits déjà rentrer ici.

En suite, nous allons continuer avec :

Clustering

Récapitulation :

- Router = 192.168.100.254

- NAS = 192.168.100.240

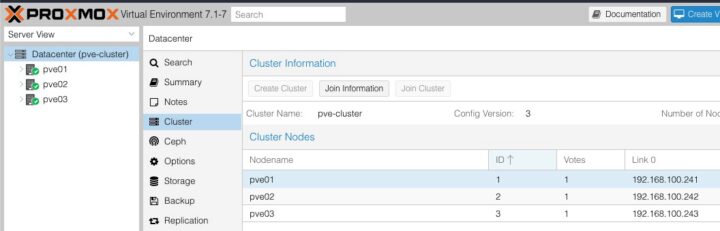

- PVE01 = 192.168.100.241

- PVE02 = 192.168.100.242

- PVE03 = 192.168.100.243

Nous allons choisir le Maitre d’opérations le PVE01 et nous rentrons dans la vue [Datacenter] => [Cluster] => [Creer Cluster]

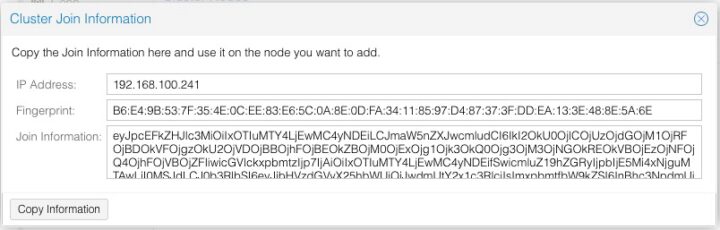

En suite, nous allons sur

[Join Information]

Exemple :

Nous allons accéder aux interfaces web des autres deux serveurs et dans le même menu [Datacenter] => [Cluster] =>[Join Cluster ]

Ça n’a marché pas donc j’ai copié les clefs ssh sur chacune de machines.

ssh-copy-id root@192.168.100.24X

Voilà :

Vérification Fonctionnalités

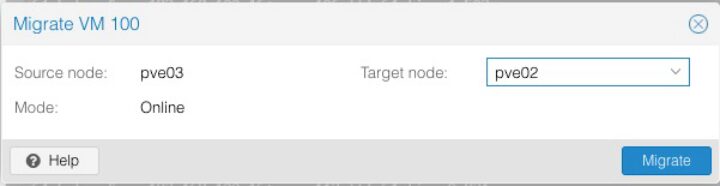

Migration

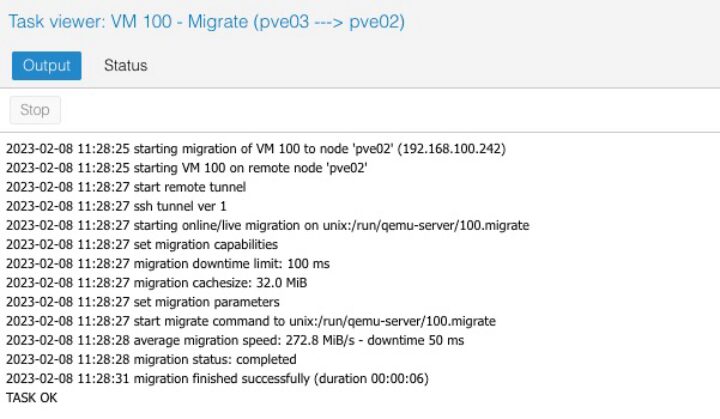

Migration d’une Machine a l’autre marche bien :

Nous voyons que la migration à durée 6 secondes.

HA Haute Disponibilite

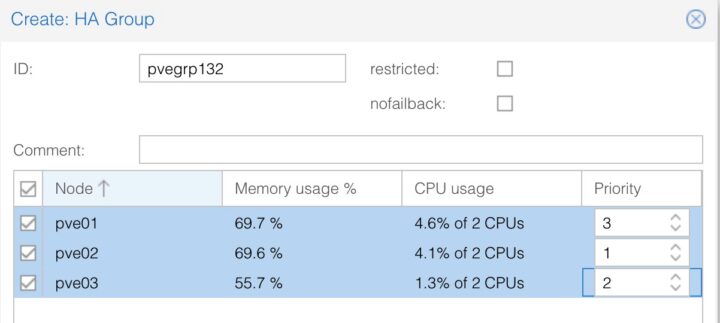

En suite pour vérifier la Haute Disponibilité, je dois créer des groupes. Chaque groupe peut avoir une différente priorité face aux machines virtuelles dont lui appartient. Je rentre dans la vue [Datacenter] => [HA] => [Groups] => [Create]

J’ai créé trois groupes :

| group | machine | priorite | preference vm |

|---|---|---|---|

| pvegrp132 | pve01 | 3 | premiere |

| pve02 | 1 | derniere | |

| pve03 | 2 | secondaire | |

| pvegrp231 | pve01 | 1 | derniere |

| pve02 | 3 | premiere | |

| pve03 | 3 | premiere |

Les machines virtuelles iront toujours vers la plus grande priorité et en cas de coupure

vont se transférer dans l’ordre de priorités.

Les machines virtuelles iront toujours vers la plus grande priorité et en cas de coupure

vont se transférer dans l’ordre de priorités.

Exemple: VM100 est dans le pvegrp132 et en conséquence roule sur pve01, pve01 tombe en pane, la VM100 va migrer vers pve03, quand pve01 revient online la vm100 va migrer vers pve01.

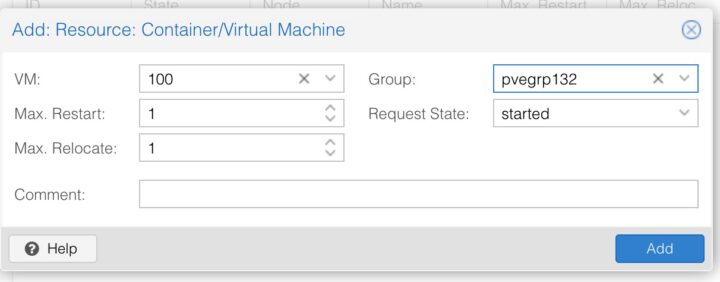

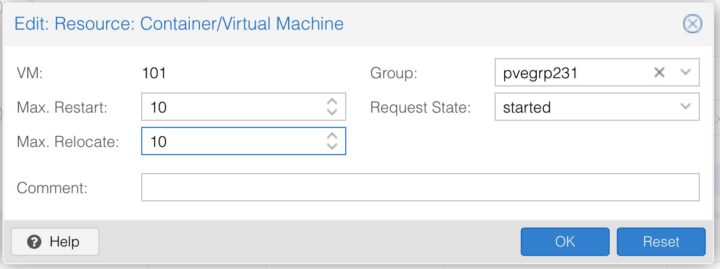

Pour configurer une machine, nous allons [Datacenter] => [ha] => Resources => [Add]

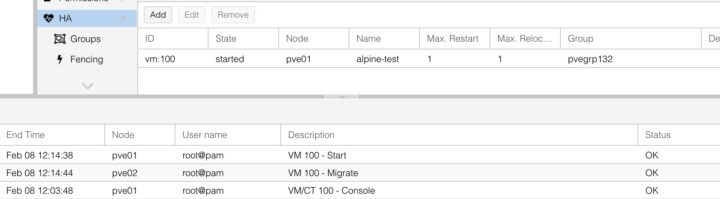

Maintenant, nous pouvons voir qu’une fois ajoute au groupe la machine a migré vers

le nœud pve01 depuis pve02.

Dans le cas quand il y a plus qu’un nœud qui tombe en panne, laissons la machine

redémarrer et faire la relocation plusieurs fois :

Je fais une coupure intentionnelle sur pve02 et pve03:

La machine 101 doit aller sur le pve03 et après sur le pve01.

Je fais une coupure intentionnelle sur pve02 et pve03:

La machine 101 doit aller sur le pve03 et après sur le pve01.

Mais, finalement pve01 perte le quorum et il ne peut pas faire la migration.

Comme nous pouvons voir la migration ce fait entre pve02 et pve03 mais au moment quand nous venons étendre aussi pve03 le système bloque.

Le système marche sur l’idée d’un quorum, donc avoir une majorité de votes pour chaque action dans un cluster de 3 il faut obligatoire 2.

Alternatif, nous forçons un peu en faisant ça :

Éditez-le /etc/pve/corosync.conf et donner au pve01 un plus grand pouvoir

logging {

debug: off

to_syslog: yes

}

nodelist {

node {

name: pve01

nodeid: 1

quorum_votes: 3 # defaut 1

ring0_addr: 192.168.100.241

}

node {

name: pve02

nodeid: 2

quorum_votes: 1

ring0_addr: 192.168.100.242

}

node {

name: pve03

nodeid: 3

quorum_votes: 1

ring0_addr: 192.168.100.243

}

}

quorum {

provider: corosync_votequorum

}

totem {

cluster_name: pve-cluster

config_version: 3

interface {

linknumber: 0

}

ip_version: ipv4-6

link_mode: passive

secauth: on

version: 2

}

Ainsi, le résultat :

Précisons qu’au moment d’un arrêt, le redémarrage sur un autre nœud prend de 2 à 3 minutes.

Mise a jour HA Wednesday_08-02-2023_22:05

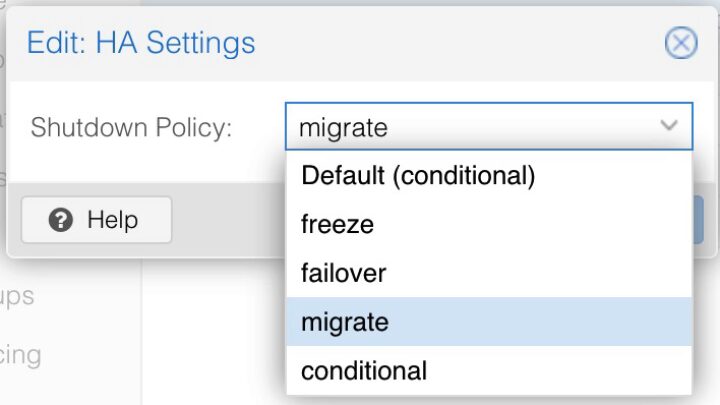

J’ai fait l’observation qu’en cas d’un arrêt (shutdown/reboot) la relocation du vm prends trop de temps, voir les 6 secondes pour faire une migration.

La configuration standard au moment de arrêt (du nœud) est : “Default(conditional)” mais il y a aussi l’option “Migrate”

Voilà, l’état de la machine est transféré entre les nœuds et la machine n’est pas arrêté :

Possibilité extension réseaux VLAN

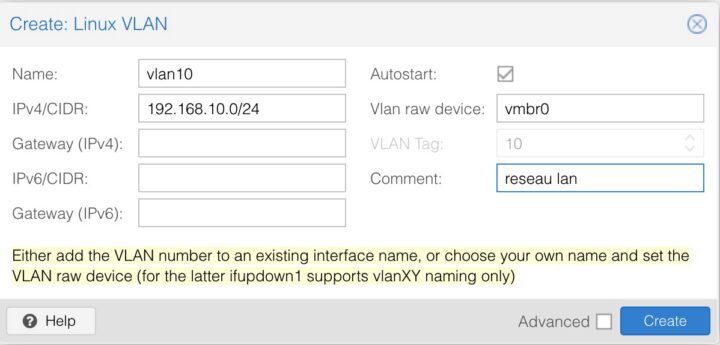

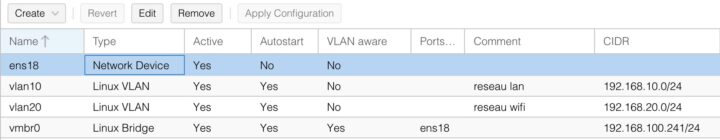

Dans le menu [Réseaux], nous pouvons creer des nouvelles interfaces réseau dont aussi des vlans. Nous pouvons faire une extension de notre réseau vlan sur la plateforme Proxmox à l’aide d’une interface pont.

Configuration de base:

[Noeud01] => [Reseau]=>[Creer]=>[Linux VLAN]

[Apply configuration] Quand toutes les configurations faites

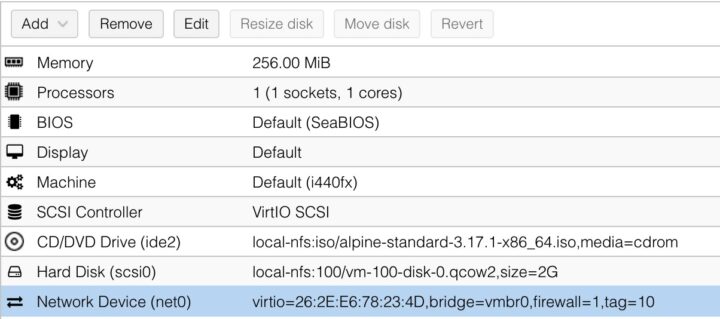

Nous pouvons désormais créer une machine et la tagger avec un tag vlan.